Inhaltsverzeichnis:

- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Um TensorFlow zu aktivieren, öffnen Sie eine Amazon Elastic Compute Cloud (Amazon EC2)-Instance des DLAMI mit Conda

- Führen Sie für TensorFlow und Keras 2 auf Python 3 mit CUDA 9.0 und MKL-DNN diesen Befehl aus: $ source activate tensorflow_p36.

- Führen Sie für TensorFlow und Keras 2 auf Python 2 mit CUDA 9.0 und MKL-DNN diesen Befehl aus:

Läuft TensorFlow entsprechend auf AWS?

TensorFlow ™ ermöglicht Entwicklern einen schnellen und einfachen Einstieg in Deep Learning in der Cloud. Du kann fang an AWS mit einem vollständig verwalteten TensorFlow Erfahrungen mit Amazonas SageMaker, eine Plattform zum Erstellen, Trainieren und Bereitstellen von Modellen für maschinelles Lernen in großem Maßstab.

Wissen Sie auch, was AWS TensorFlow ist? Kategorie: Tensorflow An AWS TensorFlow ist eine Open-Source-Bibliothek für maschinelles Lernen (ML), die weit verbreitet ist, um schwere tiefe neuronale Netze (DNNs) zu entwickeln, die ein verteiltes Training mit mehreren GPUs auf mehreren Hosts erfordern.

Die Frage ist auch, wie führe ich AWS Machine Learning aus?

Erste Schritte mit Deep Learning mit dem AWS Deep Learning AMI

- Schritt 1: Öffnen Sie die EC2-Konsole.

- Schritt 1b: Wählen Sie die Schaltfläche Instanz starten aus.

- Schritt 2a: Wählen Sie das AWS Deep Learning-AMI aus.

- Schritt 2b: Wählen Sie auf der Detailseite Weiter.

- Schritt 3a: Wählen Sie einen Instanztyp aus.

- Schritt 3b: Starten Sie Ihre Instanz.

- Schritt 4: Erstellen Sie eine neue private Schlüsseldatei.

- Schritt 5: Klicken Sie auf Instanz anzeigen, um Ihren Instanzstatus anzuzeigen.

Wie wird ein TensorFlow-Modell bereitgestellt?

- Erstellen Sie Ihr Modell. Importieren Sie das Fashion MNIST-Dataset. Trainieren und bewerten Sie Ihr Modell.

- Speichern Sie Ihr Modell.

- Untersuchen Sie Ihr gespeichertes Modell.

- Servieren Sie Ihr Modell mit TensorFlow Serving. Fügen Sie den TensorFlow Serving-Verteilungs-URI als Paketquelle hinzu: Installieren Sie TensorFlow Serving.

- Stellen Sie in TensorFlow Serving eine Anfrage an Ihr Modell. REST-Anfragen stellen.

Empfohlen:

Wie führe ich JUnit-Testfälle in Eclipse aus?

Die einfachste Möglichkeit, eine einzelne JUnit-Testmethode auszuführen, besteht darin, sie im Klasseneditor des Testfalls auszuführen: Platzieren Sie den Cursor auf dem Namen der Methode innerhalb der Testklasse. Drücken Sie Alt+Umschalt+X,T, um den Test auszuführen (oder klicken Sie mit der rechten Maustaste auf Ausführen als > JUnit-Test). Wenn Sie dieselbe Testmethode erneut ausführen möchten, drücken Sie einfach Strg+F11

Wie führe ich die AVD-App aus?

Auf einem Emulator ausführen Erstellen Sie in Android Studio ein Android Virtual Device (AVD), das der Emulator zum Installieren und Ausführen Ihrer App verwenden kann. Wählen Sie in der Symbolleiste Ihre App aus dem Dropdown-Menü Run/Debug-Konfigurationen aus. Wählen Sie im Dropdown-Menü Zielgerät das AVD aus, auf dem Sie Ihre App ausführen möchten. Klicken Sie auf Ausführen

Wie führe ich einen Docker-Container in AWS aus?

Bereitstellen von Docker-Containern Schritt 1: Richten Sie Ihren ersten Lauf mit Amazon ECS ein. Schritt 2: Erstellen Sie eine Aufgabendefinition. Schritt 3: Konfigurieren Sie Ihren Dienst. Schritt 4: Konfigurieren Sie Ihren Cluster. Schritt 5: Starten Sie Ihre Ressourcen und zeigen Sie sie an. Schritt 6: Öffnen Sie die Beispielanwendung. Schritt 7: Löschen Sie Ihre Ressourcen

Wie führe ich PyCharm aus der Ferne aus?

Ein SSH-Server sollte auf einem Remote-Host laufen, da PyCharm Remote-Interpreter über SSH-Session ausführt. Wenn Sie Ihre Quellen auf einen Remote-Computer kopieren möchten, erstellen Sie eine Bereitstellungskonfiguration, wie im Abschnitt Erstellen einer Remote-Serverkonfiguration . beschrieben

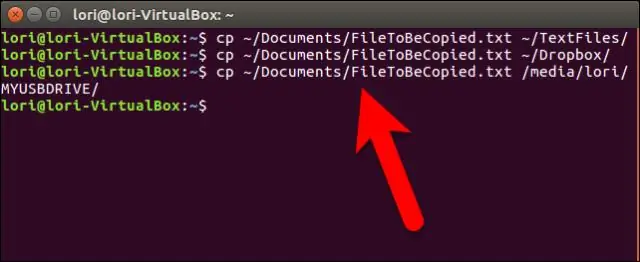

Wie führe ich ein Bash-Skript aus einem anderen Verzeichnis aus?

Wenn Sie das Skript mit chmod 755 ausführbar machen, um es auszuführen, müssen Sie nur den Pfad zum Skript eingeben. Wenn Sie sehen, dass ./script verwendet wird, teilt es der Shell mit, dass sich das Skript in demselben Verzeichnis befindet, in dem Sie es ausführen. Um den vollständigen Pfad zu verwenden, geben Sie sh /home/user/scripts/someScript . ein