- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-06-01 05:07.

SÄURE steht für Atomicity, Consistency, Isolation und Durability. Konsistenz stellt sicher, dass jede Transaktion die Datenbank von einem gültigen Zustand in einen anderen Zustand bringt. Isolation besagt, dass jede Transaktion unabhängig voneinander sein sollte, d. h. eine Transaktion sollte sich nicht auf eine andere auswirken.

Die Frage ist auch, was ist Acid in Big Data?

Zuerst, SÄURE ist ein Akronym für Atomizität, Konsistenz, Isolation und Dauerhaftigkeit. Eine Transaktion behält die Konsistenz des Zustands der Daten . Mit anderen Worten, nach dem Ausführen einer Transaktion sind alle Daten in der Datenbank ist „richtig“. Isolation bedeutet, dass Transaktionen gleichzeitig ausgeführt werden können.

Außerdem, warum ist die Säure-Compliance wichtig? Hier ist ein reales Beispiel: SÄURE-Konformität ist für Finanzinstitute kritisch, weil es die unangenehme Situation verhindert, das gleiche Geld aufgrund inkonsistenter Transaktionsabwicklung zweimal auszuzahlen.

Anschließend kann man sich auch fragen, was sind die ACID-Eigenschaften im DBMS?

Eine Transaktion in a Datenbank System muss Atomizität, Konsistenz, Isolation und Haltbarkeit aufrechterhalten - allgemein bekannt als SÄURE-Eigenschaften − um Richtigkeit, Vollständigkeit und Datenintegrität zu gewährleisten. Konsistenz − Die Datenbank muss nach jeder Transaktion in einem konsistenten Zustand bleiben.

Was ist Säure und Base in Datenbanken?

Datenbank Entwickler kennen das alle SÄURE Akronym. Es steht dass Datenbank Transaktionen sollten sein: Atomic: Alles in einer Transaktion ist erfolgreich oder die gesamte Transaktion wird zurückgesetzt. Konsequent: Eine Transaktion kann die Datenbank in einem inkonsistenten Zustand. Isoliert: Transaktionen können sich nicht gegenseitig stören.

Empfohlen:

Was ist Auftragsplanung Hadoop?

Arbeit planen. Sie können die Auftragsplanung verwenden, um die MapReduce-Aufträge und YARN-Anwendungen zu priorisieren, die auf Ihrem MapR-Cluster ausgeführt werden. Der Standard-Job-Scheduler ist der Fair Scheduler, der für eine Produktionsumgebung mit mehreren Benutzern oder Gruppen entwickelt wurde, die um Cluster-Ressourcen konkurrieren

Was ist sekundärer Namenode in Apache Hadoop?

Sekundärer NameNode in hadoop ist ein speziell dedizierter Knoten im HDFS-Cluster, dessen Hauptfunktion darin besteht, Prüfpunkte der Dateisystem-Metadaten zu übernehmen, die auf Namenode vorhanden sind. Es ist kein Backup-Namenode. Es überprüft nur den Dateisystem-Namespace von namenode

Was ist HDP in Hadoop?

Die Hortonworks Data Platform (HDP) ist eine sicherheitsreiche, unternehmenstaugliche Open-Source-Apache Hadoop-Distribution basierend auf einer zentralisierten Architektur (YARN). HDP erfüllt die Anforderungen von Data-at-Rest, unterstützt Echtzeit-Kundenanwendungen und liefert robuste Analysen, die zur Beschleunigung der Entscheidungsfindung und Innovation beitragen

Was ist die Datenherkunft in Hadoop?

Datenherkunft. Die Datenherkunft kann als Lebenszyklus und End-to-End-Fluss der Daten definiert werden. Die Datenherkunft ermöglicht es den Unternehmen, die Quellen spezifischer Geschäftsdaten zu verfolgen, wodurch sie Fehler verfolgen, die Änderungen im Prozess implementieren und die Systemmigration implementieren können, um einen erheblichen Zeitaufwand zu sparen

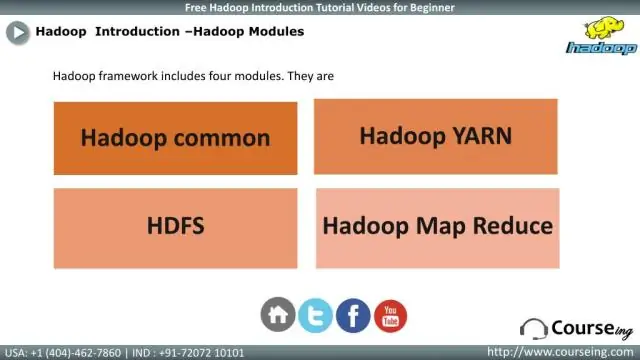

Was ist Hadoop-Framework-PPT?

PPT auf Hadoop. Die Apache Hadoop-Softwarebibliothek ist ein Framework, das die verteilte Verarbeitung großer Datensätze über Computercluster hinweg mit einfachen Programmiermodellen ermöglicht