- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Informationsgewinn = wie viel Entropie wir haben entfernt, also

Das macht Sinn: höher Informationsgewinn = mehr Entropie entfernt, was wir wollen. Im perfekten Fall würde jeder Zweig nach der Aufteilung nur eine Farbe enthalten, die Null wäre Entropie !

Außerdem, was ist Informationsgewinn und Entropie im Entscheidungsbaum?

Informationsgewinn : Die Informationsgewinn basiert auf dem Rückgang in Entropie nachdem ein Datensatz auf ein Attribut aufgeteilt wurde. Konstruieren von a Entscheidungsbaum dreht sich alles darum, das Attribut zu finden, das die höchste zurückgibt Informationsgewinn (d. h. die homogensten Zweige). Schritt 1: Berechnen Entropie des Ziels.

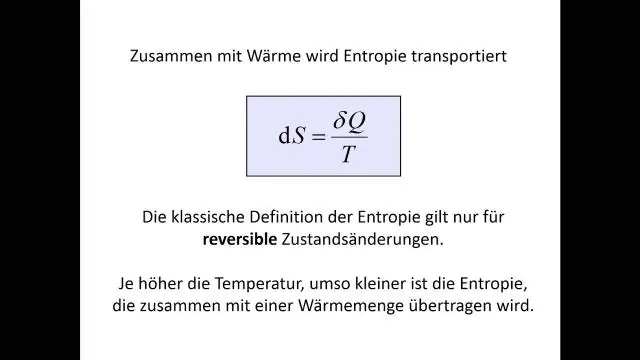

Was ist Entropie in Daten? Information Entropie ist die durchschnittliche Rate, mit der Informationen von einer stochastischen Quelle von Daten . Das Maß der Information Entropie verbunden mit jedem möglich Daten value ist der negative Logarithmus der Wahrscheinlichkeitsmassenfunktion für den Wert: wobei der durch die Wahrscheinlichkeit definierte Erwartungswert ist.

Was bedeutet in diesem Zusammenhang Informationsgewinn?

Informationsgewinn berechnet die Entropie- oder Überraschungsreduktion durch die Transformation eines Datensatzes in irgendeiner Weise. Informationsgewinn ist die Verringerung der Entropie oder Überraschung durch die Transformation eines Datensatzes und wird häufig beim Trainieren von Entscheidungsbäumen verwendet.

Was ist die Definition von Entropie im Entscheidungsbaum?

Definition : Entropie ist das Maß für Unreinheit, Unordnung oder Unsicherheit in einer Reihe von Beispielen.

Empfohlen:

Was ist ein Beispiel, das zeigt, dass eine Vermutung falsch ist?

Um zu zeigen, dass eine Vermutung falsch ist, müssen Sie nur ein Beispiel finden, in dem die Vermutung nicht wahr ist. Dieser Fall wird als Gegenbeispiel bezeichnet. Um zu zeigen, dass eine Vermutung immer wahr ist, müssen Sie sie beweisen. Ein Gegenbeispiel kann eine Zeichnung, eine Aussage oder eine Zahl sein

Was ist die Definition von Entropie im Entscheidungsbaum?

Entropie: Ein Entscheidungsbaum wird von oben nach unten von einem Wurzelknoten aufgebaut und beinhaltet die Partitionierung der Daten in Teilmengen, die Instanzen mit ähnlichen Werten (homogen) enthalten. ID3-Algorithmus verwendet Entropie, um die Homogenität einer Probe zu berechnen

Was ist das Piaget-Stadium, das mit der Adoleszenz verbunden ist?

Piagets vier Stadien Stufe Alter Ziel Sensomotorische Geburt bis 18–24 Monate Objektpermanenz Präoperational 2 bis 7 Jahre Symbolisches Denken Konkretes operatives 7 bis 11 Jahre Operatives Denken Formales operatives Jugendalter bis ins Erwachsenenalter Abstrakte Konzepte

Was ist das w3c was ist das Whatwg?

Die Web Hypertext Application Technology Working Group (WHATWG) ist eine Gemeinschaft von Menschen, die an der Entwicklung von HTML und verwandten Technologien interessiert sind. Die WHATWG wurde 2004 von Einzelpersonen von Apple Inc., der Mozilla Foundation und Opera Software, führenden Anbietern von Webbrowsern, gegründet

Was ist Entropie beim Text-Mining?

Entropie ist definiert als: Entropie ist die Summe der Wahrscheinlichkeit jedes Labels mal der logarithmischen Wahrscheinlichkeit desselben Labels. Wie kann ich Entropie und maximale Entropie in Bezug auf Text Mining anwenden?