- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:13.

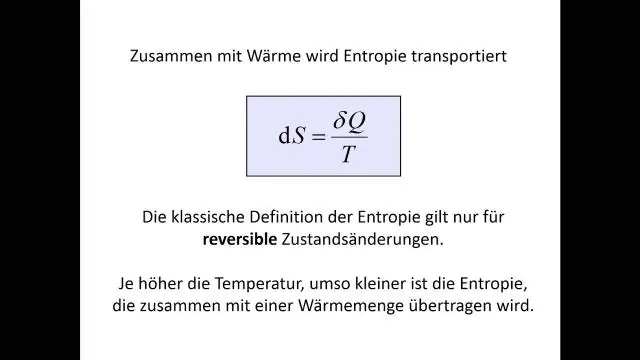

Entropie : EIN Entscheidungsbaum wird von oben nach unten von einem Wurzelknoten aufgebaut und beinhaltet die Partitionierung der Daten in Teilmengen, die Instanzen mit ähnlichen Werten (homogen) enthalten. ID3-Algorithmus verwendet Entropie um die Homogenität einer Probe zu berechnen.

Die Leute fragen auch, was ist die Definition von Entropie beim maschinellen Lernen?

Entropie , in Bezug auf maschinelles Lernen , ist ein Maß für die Zufälligkeit der verarbeiteten Informationen. Je höher die Entropie , desto schwieriger ist es, aus diesen Informationen Schlussfolgerungen zu ziehen. Das Werfen einer Münze ist ein Beispiel für eine Aktion, die zufällige Informationen liefert. Das ist die Essenz von Entropie.

Was ist neben dem oben Gesagten Informationsgewinn und Entropie im Entscheidungsbaum? Die Informationsgewinn basiert auf dem Rückgang in Entropie nachdem ein Dataset auf ein Attribut aufgeteilt wurde. Konstruieren von a Entscheidungsbaum dreht sich alles darum, das Attribut zu finden, das die höchste zurückgibt Informationsgewinn (d. h. die homogensten Zweige). Das Ergebnis ist die Informationsgewinn , oder Abnahme in Entropie.

Wissen Sie auch, was der Mindestwert der Entropie in einem Entscheidungsbaum ist?

Entropie ist niedrigste an den Extremen, wenn die Blase entweder keine positiven Instanzen oder nur positive Instanzen enthält. Das heißt, wenn die Blase rein ist, ist die Unordnung 0. Entropie ist in der Mitte am höchsten, wenn die Blase gleichmäßig auf positive und negative Instanzen verteilt ist.

Was ist Entropie im Random Forest?

Was ist Entropie? und warum Informationsgewinn wichtig ist Entscheidung Bäume? Nasir Islam Sujan. 29.06.2018 · 5 Min. Lesezeit. Laut Wikipedia, Entropie bezieht sich auf Unordnung oder Unsicherheit. Definition: Entropie ist das Maß für Unreinheit, Unordnung oder Unsicherheit in einer Reihe von Beispielen.

Empfohlen:

Was ist die Definition von qualitativen und quantitativen Beobachtungen?

Es beinhaltet die Beobachtung von allem, was gemessen werden kann, wie zum Beispiel die Unterschiede in Form, Größe, Farbe, Volumen und Zahlen. Qualitative Beobachtung ist ein subjektiver Prozess zum Sammeln von Daten oder Informationen, während quantitative Beobachtung ein objektiver Prozess zum Sammeln von Daten oder Informationen ist

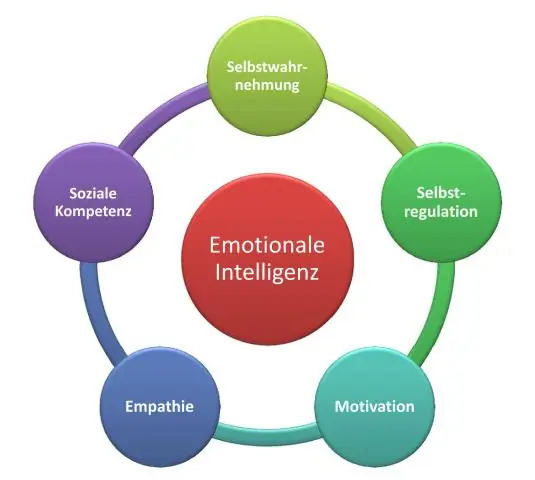

Was ist die Definition von Intelligenz in der Psychologie?

Intelligenz ist die Fähigkeit zu denken, aus Erfahrungen zu lernen, Probleme zu lösen und sich an neue Situationen anzupassen. Psychologen glauben, dass es ein Konstrukt gibt, das als allgemeine Intelligenz (g) bekannt ist und die allgemeinen Intelligenzunterschiede zwischen Menschen erklärt

Welche der folgenden Definitionen ist die beste Definition von Interoperabilität?

Interoperabilität ist die Fähigkeit verschiedener IT-Systeme und Softwareanwendungen, zu kommunizieren, Daten genau, effektiv und konsistent auszutauschen und die ausgetauschten Informationen zu nutzen. Es ist grundlegend für den Erfolg von EHRs

Was ist die Definition von multipler Intelligenz?

Die Theorie der multiplen Intelligenzen differenziert die menschliche Intelligenz in spezifische „Modalitäten“, anstatt Intelligenz als von einer einzigen allgemeinen Fähigkeit dominiert zu betrachten. Howard Gardner schlug dieses Modell in seinem 1983 erschienenen Buch Frames of Mind: The Theory of Multiple Intelligences vor

Was ist die Definition von Artefakt in der Geographie?

Artefakt. Ein von Menschen gemachtes Objekt; bezieht sich oft auf ein primitives Werkzeug oder ein anderes Relikt aus einer früheren Zeit. Gebaute Umwelt. Der Teil der physischen Landschaft, der die materielle Kultur repräsentiert; die Gebäude, Straßen, Brücken und ähnliche große und kleine Bauwerke der Kulturlandschaft