- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Apache Parkett ist ein kostenloses und Open-Source-Spalten-orientiertes Daten Lagerung Format des Apache Hadoop-Ökosystems. Es ist kompatibel mit den meisten Daten Verarbeitungsframeworks in der Hadoop-Umgebung. Es bietet effiziente Daten Komprimierungs- und Kodierungsschemata mit verbesserter Leistung, um komplexe Daten in großen Mengen.

Also, was ist das Parkett-Dateiformat?

Parkett , eine Open Source Datei Format für Hadoop. Parkett speichert verschachtelte Datenstrukturen in einer flachen Spalte Format . Im Vergleich zu einem traditionellen Ansatz, bei dem Daten zeilenorientiert gespeichert werden, Parkett ist effizienter in Bezug auf Speicher und Leistung.

Und wofür wird Parkett verwendet? Parkett ist ein Open-Source-Dateiformat, das für jedes Projekt im Hadoop-Ökosystem verfügbar ist. Apache Parkett ist für ein effizientes und leistungsstarkes flaches spaltenförmiges Speicherformat von Daten im Vergleich zu zeilenbasierten Dateien wie CSV- oder TSV-Dateien ausgelegt.

Wie speichert das Parkettformat außerdem Daten?

DATEN BLOCK Jeder Block im Parkett Datei ist gelagert in Form von Reihengruppen. So, Daten in einem Parkett Datei ist in mehrere Zeilengruppen unterteilt. Diese Zeilengruppen bestehen wiederum aus einem oder mehreren Spaltenblöcken, die einer Spalte im Daten einstellen. Die Daten für jeden in Seitenform geschriebenen Spaltenblock.

Ist Parkett menschenlesbar?

ORK, Parkett , und Avro sind auch Maschinen- lesbar Binärformate, d.h. die Dateien sehen aus wie Kauderwelsch zu Menschen . Wenn Sie brauchen ein Mensch - lesbar Format wie JSON oder XML, dann sollten Sie sich wahrscheinlich noch einmal überlegen, warum Sie Hadoop überhaupt verwenden.

Empfohlen:

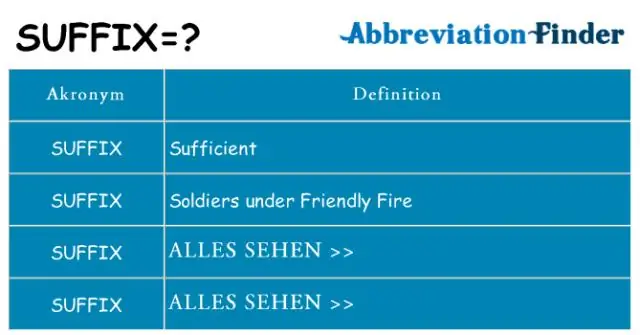

Was ist das Suffix, das schlecht bedeutet?

Anti-Präfix bedeutet entgegengesetzt, gegen oder entgegenwirkend. dys-Präfix bedeutet schlecht, schwierig oder schmerzhaft. Endo

Was ist das Piaget-Stadium, das mit der Adoleszenz verbunden ist?

Piagets vier Stadien Stufe Alter Ziel Sensomotorische Geburt bis 18–24 Monate Objektpermanenz Präoperational 2 bis 7 Jahre Symbolisches Denken Konkretes operatives 7 bis 11 Jahre Operatives Denken Formales operatives Jugendalter bis ins Erwachsenenalter Abstrakte Konzepte

Was ist das w3c was ist das Whatwg?

Die Web Hypertext Application Technology Working Group (WHATWG) ist eine Gemeinschaft von Menschen, die an der Entwicklung von HTML und verwandten Technologien interessiert sind. Die WHATWG wurde 2004 von Einzelpersonen von Apple Inc., der Mozilla Foundation und Opera Software, führenden Anbietern von Webbrowsern, gegründet

Welche Art von Netzwerk ist das Internet Das Internet ist ein Beispiel für ein Netzwerk?

Das Internet ist ein sehr gutes Beispiel für ein öffentliches WAN (Wide Area Network). Ein Unterschied zwischen WAN und anderen Netzwerktypen besteht darin, dass es

Kann ein Roomba Parkett reinigen?

Jawohl! Roomba nimmt unglaublich viel Schmutz, Staub, Tierhaare und andere Ablagerungen von Ihren Teppichen und Hartböden auf. Roomba wechselt automatisch von einer Bodenfläche zur nächsten, einschließlich Teppichen, Vorlegern, Fliesen, Linoleum und Holzböden