- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Der große Vorteil von Karte verkleinern ist, dass es einfach ist, die Datenverarbeitung über mehrere Rechenknoten zu skalieren. Unter dem Karte verkleinern Modells werden die Datenverarbeitungsprimitiven Mapper genannt und Reduzierstücke . Zerlegen einer Datenverarbeitungsanwendung in Mapper und Reduzierstücke ist manchmal nicht trivial.

Wenn man dies im Blick behält, was ist Mapper und Reducer?

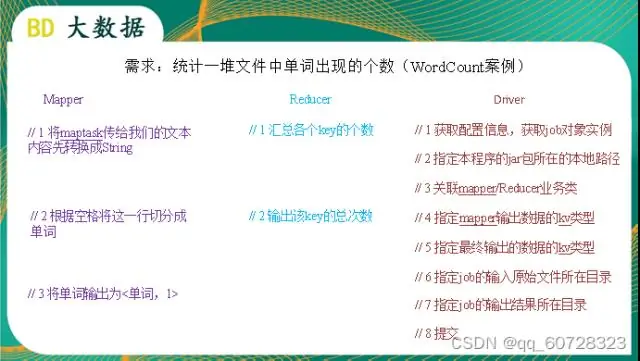

MapReduce besteht aus zwei Schlüsselfunktionen: Mapper und Reducer . Mapper ist eine Funktion, die die Eingabedaten verarbeitet. Die Mapper verarbeitet die Daten und erstellt mehrere kleine Datenblöcke.

Was ist ein Mapper? EIN Mapper kann Daten beschreiben Mapper sowie eine Person, die geografische Karten erstellt. Aufgaben eines geografischen Mapper oder Kartierungstechniker umfassen das Sammeln und Verarbeiten von geografischen Daten, um eine Karte eines Gebiets zu erstellen.

Was ist also der Nutzen von Mapper und Reducer in Hadoop?

Laut der Apache Software Foundation ist das Hauptziel von Karte / Reduzieren besteht darin, den Eingabedatensatz in unabhängige Blöcke aufzuteilen, die vollständig parallel verarbeitet werden. Die Hadoop MapReduce Framework sortiert die Ausgaben der Karten, die dann in die reduzieren Aufgaben.

Wozu dient Mapper in Hadoop?

Im Lauf Hadoop Job, Anwendungen implementieren in der Regel die Mapper und Reduzierer-Schnittstellen zum Bereitstellen der Karte (einzelne Aufgaben, die Eingabedatensätze in Zwischendatensätze umwandeln) und Reduzierverfahren zum Reduzieren eines Satzes von Zwischenwerten, die einen Schlüssel teilen, auf einen kleineren Satz von Werten.

Empfohlen:

Was ist Auftragsplanung Hadoop?

Arbeit planen. Sie können die Auftragsplanung verwenden, um die MapReduce-Aufträge und YARN-Anwendungen zu priorisieren, die auf Ihrem MapR-Cluster ausgeführt werden. Der Standard-Job-Scheduler ist der Fair Scheduler, der für eine Produktionsumgebung mit mehreren Benutzern oder Gruppen entwickelt wurde, die um Cluster-Ressourcen konkurrieren

Was ist sekundärer Namenode in Apache Hadoop?

Sekundärer NameNode in hadoop ist ein speziell dedizierter Knoten im HDFS-Cluster, dessen Hauptfunktion darin besteht, Prüfpunkte der Dateisystem-Metadaten zu übernehmen, die auf Namenode vorhanden sind. Es ist kein Backup-Namenode. Es überprüft nur den Dateisystem-Namespace von namenode

Was ist HDP in Hadoop?

Die Hortonworks Data Platform (HDP) ist eine sicherheitsreiche, unternehmenstaugliche Open-Source-Apache Hadoop-Distribution basierend auf einer zentralisierten Architektur (YARN). HDP erfüllt die Anforderungen von Data-at-Rest, unterstützt Echtzeit-Kundenanwendungen und liefert robuste Analysen, die zur Beschleunigung der Entscheidungsfindung und Innovation beitragen

Was ist eine Mapper-Klasse?

Die Mapper-Klasse ist ein generischer Typ mit vier formalen Parametertypen, die die Typen Eingabeschlüssel, Eingabewert, Ausgabeschlüssel und Ausgabewert der Kartenfunktion angeben

Was ist die Verwendung von Mapper in Java?

Der Jackson Object Mapper kann JSON in Objekte von von Ihnen entwickelten Klassen oder in Objekte des integrierten JSON-Baummodells analysieren, das später in diesem Tutorial erläutert wird. Übrigens wird es ObjectMapper genannt, weil es JSON in Java-Objekte (Deserialisierung) oder Java-Objekte in JSON (Serialisierung) abbildet