- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-06-01 05:07.

EIN Spark-DataFrame ist eine verteilte Sammlung von Daten, die in benannten Spalten organisiert ist und Operationen zum Filtern, Gruppieren oder Berechnen von Aggregaten bereitstellt und mit. verwendet werden kann Funke SQL. Datenrahmen kann aus strukturierten Datendateien, vorhandenen RDDs, Tabellen in Hive oder externen Datenbanken erstellt werden.

In ähnlicher Weise können Sie sich fragen, was ein DataFrame in Scala ist.

Eine verteilte Sammlung von Daten, die in benannte Spalten organisiert sind. EIN Datenrahmen entspricht einer relationalen Tabelle in Spark SQL. So wählen Sie eine Spalte aus dem Datenrahmen , verwende Methode anwenden in Scala und col in Java.

was nützt lit in Scala? ( zündete ist Gebraucht in Funke um einen Literalwert in eine neue Spalte umzuwandeln.) Da concat Spalten als Argumente verwendet zündete muss sein Gebraucht Hier.

Was ist der Unterschied zwischen RDD und DataFrame in Spark?

Funken-RDD APIs - An RDD steht für Resilient Distributed Datasets. Es ist eine schreibgeschützte Partitionssammlung von Datensätzen. RDD ist die grundlegende Datenstruktur von Funke . DataFrame in Spark ermöglicht es Entwicklern, einer verteilten Datensammlung eine Struktur aufzuerlegen, die eine Abstraktion auf höherer Ebene ermöglicht.

Was macht withColumn in Spark?

Funke mitSpalte () Funktion ist zum Umbenennen, Ändern des Werts, Konvertieren des Datentyps einer vorhandenen DataFrame-Spalte und auch kann verwendet werden, um eine neue Spalte zu erstellen, in diesem Beitrag, I Wille führen Sie durch häufig verwendete DataFrame-Spaltenoperationen mit Scala und Pyspark-Beispiele.

Empfohlen:

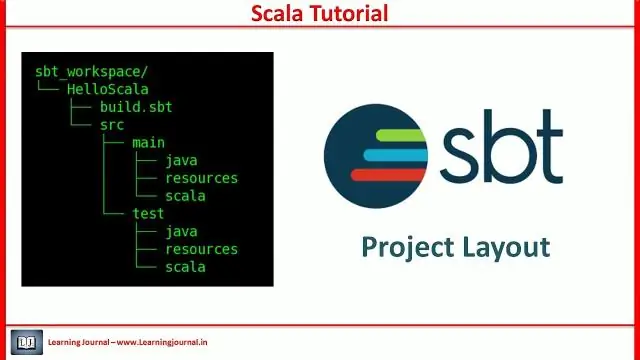

Was ist das SBT-Projekt in Scala?

Sbt ist ein Open-Source-Build-Tool für Scala- und Java-Projekte, ähnlich wie Javas Maven und Ant. Seine Hauptmerkmale sind: Native Unterstützung für das Kompilieren von Scala-Code und die Integration mit vielen Scala-Testframeworks. Kontinuierliches Kompilieren, Testen und Bereitstellen

Was ist DataFrame-Loc?

Pandas DataFrame: loc()-Funktion Die loc()-Funktion wird verwendet, um auf eine Gruppe von Zeilen und Spalten über Label(s) oder ein boolesches Array zuzugreifen. loc[] ist hauptsächlich Label-basiert, kann aber auch mit einem booleschen Array verwendet werden . Ein boolesches Array mit der gleichen Länge wie die zu schneidende Achse, z. [Richtig, falsch, wahr]

Was ist RDD in Scala?

Resilient Distributed Datasets (RDD) ist eine grundlegende Datenstruktur von Spark. Es ist eine unveränderliche verteilte Sammlung von Objekten. RDDs können jede Art von Python-, Java- oder Scala-Objekten enthalten, einschließlich benutzerdefinierter Klassen. Formal ist ein RDD eine schreibgeschützte, partitionierte Sammlung von Datensätzen

Was ist in Scala überschreiben?

Überschreiben der Scala-Methode. Wenn eine Unterklasse denselben Methodennamen hat wie in der übergeordneten Klasse definiert, wird dies als Methodenüberschreibung bezeichnet. Wenn die Unterklasse eine bestimmte Implementierung für die in der übergeordneten Klasse definierte Methode bereitstellen möchte, überschreibt sie die Methode der übergeordneten Klasse

Was ist implizite Klasse in Scala?

Scala 2.10 hat eine neue Funktion namens implizite Klassen eingeführt. Eine implizite Klasse ist eine Klasse, die mit dem impliziten Schlüsselwort gekennzeichnet ist. Dieses Schlüsselwort macht den primären Konstruktor der Klasse für implizite Konvertierungen verfügbar, wenn sich die Klasse im Gültigkeitsbereich befindet. Implizite Klassen wurden in SIP-13 . vorgeschlagen