- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-06-01 05:07.

Belastbare verteilte Datasets ( RDD ) ist eine grundlegende Datenstruktur von Spark. Es ist eine unveränderliche verteilte Sammlung von Objekten. RDDs kann jede Art von Python, Java oder. enthalten Scala Objekte, einschließlich benutzerdefinierter Klassen. Formal ein RDD ist eine schreibgeschützte, partitionierte Sammlung von Datensätzen.

Die Frage ist auch, was ist der Unterschied zwischen RDD und DataFrame?

RDD - RDD ist eine verteilte Sammlung von Datenelementen, die auf viele Maschinen verteilt sind in dem Cluster. RDDs sind eine Menge von Java- oder Scala-Objekten, die Daten darstellen. Datenrahmen - EIN Datenrahmen ist eine verteilte Sammlung von Daten, die in benannte Spalten organisiert sind. Es ist konzeptionell gleich einer Tabelle in einem relationale Datenbank.

Außerdem, wie wird RDD verteilt? Robust Verteilt Datensätze ( RDDs ) Sie sind ein verteilt Sammlung von Objekten, die im Arbeitsspeicher oder auf Festplatten verschiedener Maschinen eines Clusters gespeichert sind. Ein einzelnes RDD kann in mehrere logische Partitionen unterteilt werden, sodass diese Partitionen auf verschiedenen Maschinen eines Clusters gespeichert und verarbeitet werden können.

Wie funktioniert Funken-RDD?

RDDs in Funke haben eine Sammlung von Datensätzen, die Partitionen enthalten. RDDs in Funke sind in kleine logische Datenblöcke unterteilt, die als Partitionen bezeichnet werden. Wenn eine Aktion ausgeführt wird, wird pro Partition eine Aufgabe gestartet. Partitionen in RDDs sind die Grundeinheiten der Parallelität.

Was ist schneller RDD oder DataFrame?

RDD - Beim Ausführen einfacher Gruppierungs- und Aggregationsoperationen RDD API ist langsamer. Datenrahmen - Bei der Durchführung explorativer Analysen, Erstellung aggregierter Statistiken zu Daten, Datenrahmen sind Schneller . RDD - Wenn Sie Transformationen und Aktionen auf niedriger Ebene wünschen, verwenden wir RDDs . Auch wenn wir Abstraktionen auf hoher Ebene benötigen, verwenden wir RDDs.

Empfohlen:

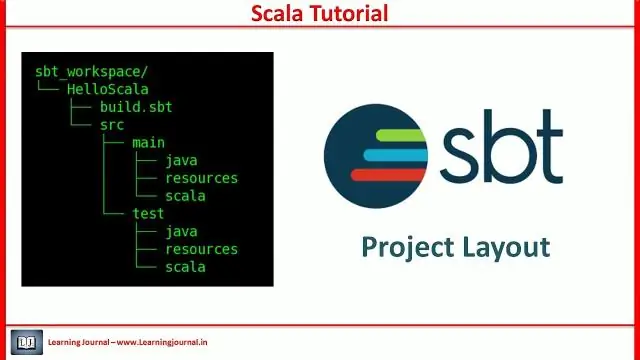

Was ist das SBT-Projekt in Scala?

Sbt ist ein Open-Source-Build-Tool für Scala- und Java-Projekte, ähnlich wie Javas Maven und Ant. Seine Hauptmerkmale sind: Native Unterstützung für das Kompilieren von Scala-Code und die Integration mit vielen Scala-Testframeworks. Kontinuierliches Kompilieren, Testen und Bereitstellen

Was sind Schauspieler in Scala?

Das primäre Nebenläufigkeitskonstrukt von Scala sind Akteure. Akteure sind im Grunde nebenläufige Prozesse, die durch den Austausch von Nachrichten kommunizieren. Aktoren können auch als eine Form von aktiven Objekten angesehen werden, bei denen der Aufruf einer Methode dem Senden einer Nachricht entspricht

Was ist DataFrame in Spark Scala?

Ein Spark DataFrame ist eine verteilte Sammlung von Daten, die in benannten Spalten organisiert sind und Operationen zum Filtern, Gruppieren oder Berechnen von Aggregaten bereitstellen und mit Spark SQL verwendet werden können. DataFrames können aus strukturierten Datendateien, vorhandenen RDDs, Tabellen in Hive oder externen Datenbanken erstellt werden

Was ist in Scala überschreiben?

Überschreiben der Scala-Methode. Wenn eine Unterklasse denselben Methodennamen hat wie in der übergeordneten Klasse definiert, wird dies als Methodenüberschreibung bezeichnet. Wenn die Unterklasse eine bestimmte Implementierung für die in der übergeordneten Klasse definierte Methode bereitstellen möchte, überschreibt sie die Methode der übergeordneten Klasse

Was ist implizite Klasse in Scala?

Scala 2.10 hat eine neue Funktion namens implizite Klassen eingeführt. Eine implizite Klasse ist eine Klasse, die mit dem impliziten Schlüsselwort gekennzeichnet ist. Dieses Schlüsselwort macht den primären Konstruktor der Klasse für implizite Konvertierungen verfügbar, wenn sich die Klasse im Gültigkeitsbereich befindet. Implizite Klassen wurden in SIP-13 . vorgeschlagen