- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-06-01 05:07.

Starte das Funke Master auf mehreren Nodes und stellen Sie sicher, dass diese Nodes das gleiche haben Tierpfleger Konfiguration für ZooKeeper URL und Verzeichnis.

Information.

| Systemeigenschaft | Bedeutung |

|---|---|

| Funke .einsetzen. Tierpfleger .dir | Das Verzeichnis in ZooKeeper Wiederherstellungsstatus speichern (Standard: / Funke ). Dies kann optional sein |

Können Sie Spark lokal ausführen?

Funkendose Sein Lauf Verwenden des integrierten eigenständigen Cluster-Schedulers im lokal Modus. Dies bedeutet, dass alle Funke Prozesse sind Lauf innerhalb derselben JVM - effektiv eine einzelne Multithread-Instanz von Funke.

Zweitens, kann Spark ohne Hadoop verwendet werden? Wie pro Funke Dokumentation, Funkendose Lauf ohne Hadoop . Sie können es als Standalone-Modus ausführen ohne jeder Ressourcenmanager. Wenn Sie jedoch in einem Multi-Node-Setup laufen möchten, benötigen Sie einen Ressourcenmanager wie YARN oder Mesos und ein verteiltes Dateisystem wie HDFS , S3 usw. Ja, Funke kann Lauf ohne hadoop.

Außerdem sollten Sie wissen, warum ZooKeeper in Hadoop verwendet wird.

Tierpfleger in Hadoop kann als zentralisiertes Repository angesehen werden, in dem verteilte Anwendungen Daten ablegen und Daten daraus abrufen können. es ist Gebraucht um das verteilte System unter Verwendung seiner Synchronisations-, Serialisierungs- und Koordinationsziele als eine Einheit zusammenzuarbeiten.

Wie funktioniert Spark Standalone?

Eigenständige mode ist ein einfacher Cluster-Manager, der in Funke . Es macht es einfach, einen Cluster einzurichten, der Funke selbst verwaltet und kann unter Linux, Windows oder Mac OSX ausgeführt werden. Oft ist es die einfachste Art zu laufen Funke Anwendung in einer Clusterumgebung. Erfahren Sie, wie Sie installieren Apache Spark Auf Eigenständige Modus.

Empfohlen:

Was ist MAP Side Join in Spark?

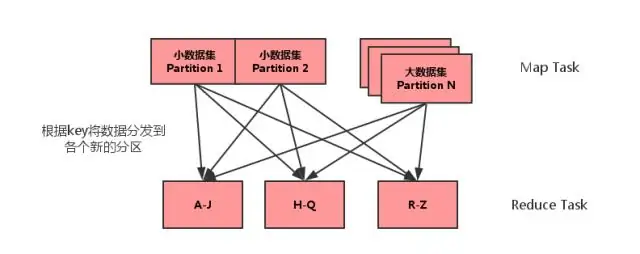

Map Side Join ist ein Prozess, bei dem Joins zwischen zwei Tabellen in der Map-Phase ohne Beteiligung der Reduce-Phase durchgeführt werden. Map-Side-Joins ermöglichen das Laden einer Tabelle in den Speicher, wodurch ein sehr schneller Join-Vorgang gewährleistet wird, der vollständig innerhalb eines Mappers ausgeführt wird und das auch, ohne sowohl Map- als auch Reduce-Phasen verwenden zu müssen

Was ist neu in Spark?

Abgesehen von Fehlerbehebungen gibt es in Spark 2.4 2 neue Funktionen: SPARK-22239 Benutzerdefinierte Fensterfunktionen mit Pandas UDF. SPARK-22274 Benutzerdefinierte Aggregationsfunktionen mit pandas udf. Wir glauben, dass diese neuen Funktionen die Akzeptanz von Pandas UDF weiter verbessern werden, und wir werden Pandas UDF in den nächsten Versionen weiter verbessern

Muss ich Hadoop für Spark lernen?

Nein, Sie müssen Hadoop nicht lernen, um Spark zu lernen. Spark war ein unabhängiges Projekt. Aber nach YARN und Hadoop 2.0 wurde Spark populär, weil Spark zusammen mit anderen Hadoop-Komponenten auf HDFS laufen kann. Hadoop ist ein Framework, in dem Sie MapReduce-Jobs schreiben, indem Sie Java-Klassen erben

Welche Python-Version verwendet Spark?

Spark läuft auf Java 8+, Python 2.7+/3.4+ und R 3.1+. Für die Scala-API bietet Spark 2.3. 0 verwendet Scala 2.11. Sie benötigen eine kompatible Scala-Version (2.11

Wie richte ich den Spark Instant Messenger ein?

Spark IM-Setup-Anleitung Laden Sie Spark von der Spark IM-Website herunter. Installieren und starten Sie Spark auf Ihrem Computer. Geben Sie Ihren Olark-Benutzernamen in das obere Feld ein, Ihr Passwort in das mittlere Feld und „@olark.com“für die Domain. Drücken Sie die Eingabetaste und Sie werden bei Spark IM angemeldet! Viel Spaß beim Chatten