- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Nein, tust du nicht muss Hadoop lernen zu LearnSpark . Funke war ein eigenständiges Projekt. Aber nach YARNand Hadoop 2.0, Funke wurde populär, weil Funke kann zusammen mit anderen auf HDFS laufen Hadoop Komponenten. Hadoop ist ein Framework, in dem Sie einen MapReduce-Job schreiben, indem Sie Java-Klassen erben.

Was ist besser, um Spark oder Hadoop zu lernen?

Der erste und wichtigste Unterschied ist die Kapazität des RAM und seine Verwendung. Funke Verwendet mehr Direktzugriffsspeicherals Hadoop , aber es „frisst“weniger Internet- oder Disc-Speicher, wenn Sie also Hadoop , es ist besser eine leistungsstarke Maschine mit großem internen Speicher zu finden.

Zweitens, ist Hadoop leicht zu erlernen? Hadoop Programmierung ist Einfacher auch für Leute mit SQL-Kenntnissen - dank Pig und Hive. Studenten oder Fachleute ohne Programmierkenntnisse, die nur grundlegende SQL-Kenntnisse haben, können es beherrschen Hadoop durch umfassendes Hands-on Hadoop Ausbildung, wenn sie den Eifer und die Bereitschaft dazu haben lernen.

Außerdem wurde gefragt, wie lange es dauert, Hadoop zu lernen?

ca. 3-4 Monate

Ersetzt der Funke Hadoop?

Funke kann nie sein Ersatz zum Hadoop ! Funke ist eine Verarbeitungs-Engine, die zusätzlich zum Hadoop Ökosystem. Wie in der obigen Architektur gezeigt, Funke kommt anstelle von MapReduce in den Hadoop Ökosystem. Es gibt andere Komponenten in der Hadoop Architektur zur Verarbeitung von Daten wie Pig andHive.

Empfohlen:

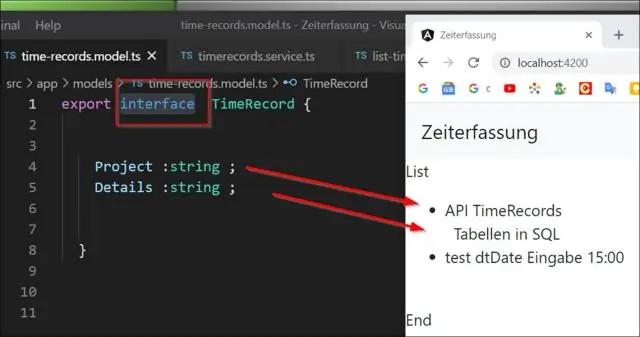

Muss ich TypeScript für Angular 2 verwenden?

TypeScript ist nicht erforderlich, um Angular2 zu verwenden. Es ist nicht einmal die Standardeinstellung. Allerdings wäre es von Vorteil, wenn Sie von TypeScript lernen würden, wenn Ihr Job ausschließlich die Frontend-Entwicklung speziell mit Angular2.0 erfordert. Sogar der offizielle 5 Min Quickstart-Artikel beginnt mit einfachem JavaScript

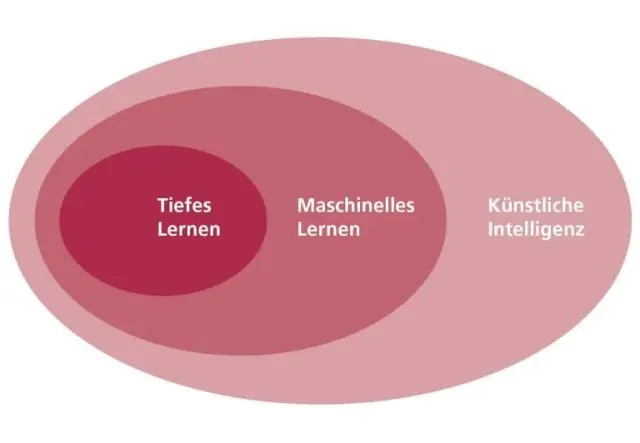

Was soll ich für maschinelles Lernen lernen?

Es wäre besser, wenn Sie sich ausführlich über das folgende Thema informieren, bevor Sie mit dem Erlernen des maschinellen Lernens beginnen. Wahrscheinlichkeitstheorie. Lineare Algebra. Graphentheorie. Optimierungstheorie. Bayessche Methoden. Infinitesimalrechnung. Multivariate Berechnung. Und Programmiersprachen und Datenbanken wie:

Muss ich für Visual Voicemail AT&T bezahlen?

Sie zahlen nicht für Visual Voicemail. Die Leitungsgebühr von 40 USD gilt für unbegrenztes Sprechen und Texten, Visual Voicemail ist kostenlos enthalten. Sie können Visualvoicemail entfernen lassen, aber die Gebühr von 40 USD bleibt bestehen. Du kannst es nicht entfernen

Wie lange muss ich für die PMP-Prüfung lernen?

Es zeigt, dass Aspiranten nur eine Woche oder mehr als 6 Monate Vorbereitung benötigen, um die PMP®-Prüfung zu bestehen. Die durchschnittliche Zeit beträgt etwa 2 Monate mit 3 Stunden täglichem Lernen (weitere Informationen finden Sie in der Umfrage ausführliche Diskussion)

Was ist besser, um Spark oder Hadoop zu lernen?

Nein, es ist nicht zwingend erforderlich, Hadoop zuerst zu erlernen, um Spark zu erlernen, aber Grundkenntnisse in Hadoop und HDFS werden Ihnen beim Erlernen von Spark einen Vorteil verschaffen. Spark ist eine aufstrebende Technologie und ist eine Marktbegeisterung bevorzugter in der Branche