Inhaltsverzeichnis:

- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-06-01 05:07.

Funkendose Sein Lauf Verwenden des integrierten eigenständigen Cluster-Schedulers im lokal Modus. Dies bedeutet, dass alle Funke Prozesse sind Lauf innerhalb derselben JVM - effektiv eine einzelne Multithread-Instanz von Funke.

Wie führe ich in diesem Zusammenhang Apache Spark lokal aus?

Die folgenden Schritte zeigen, wie Sie Apache Spark installieren

- Schritt 1: Überprüfen der Java-Installation.

- Schritt 2: Überprüfen der Scala-Installation.

- Schritt 3: Scala herunterladen.

- Schritt 4: Scala installieren.

- Schritt 5: Herunterladen von Apache Spark.

- Schritt 6: Installieren von Spark.

- Schritt 7: Überprüfen der Spark-Installation.

Können wir Spark auch ohne Hadoop betreiben? Wie pro Funke Dokumentation, Spark kann ohne Hadoop ausgeführt werden . Du können starte es als Standalone-Modus ohne jeder Ressourcenmanager. Doch wenn Sie möchte Lauf im Multi-Node-Setup, Sie benötigen einen Ressourcenmanager wie YARN oder Mesos und ein verteiltes Dateisystem wie HDFS , S3 usw. Ja, Funke kann ohne Hadoop laufen.

Wie führe ich Spark im Standalone-Modus aus?

Installieren Spark Standalone-Modus , platzieren Sie einfach eine kompilierte Version von Funke auf jedem Knoten im Cluster. Sie können vorgefertigte Versionen von Funke mit jedem Release oder bauen Sie es selbst.

Kann Spark unter Windows laufen?

EIN Funke Anwendung kann sei ein Fenster -Shell-Skript oder so kann ein benutzerdefiniertes Programm in geschriebenem Java, Scala, Python oder R sein. Sie benötigen Fenster auf Ihrem System installierte ausführbare Dateien zu Lauf diese Anwendungen.

Empfohlen:

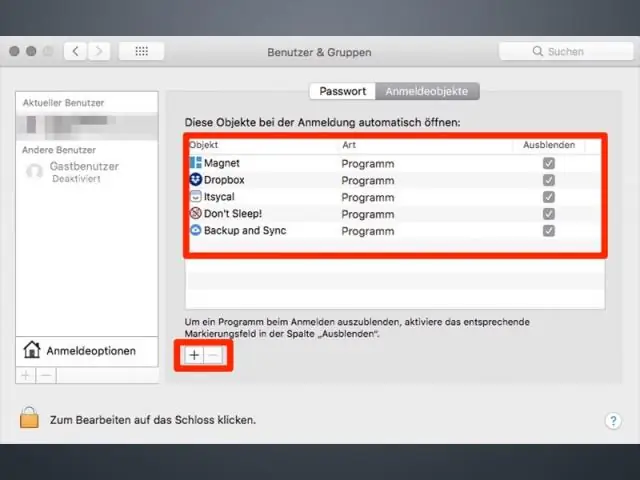

Wie kann ich ein Programm beim Start auf dem Mac ausführen?

Hinzufügen von Startobjekten zu Ihrem Mac in den Systemeinstellungen Melden Sie sich bei Ihrem Mac mit dem Konto an, das Sie mit einem Startobjekt verwenden. Wählen Sie Systemeinstellungen aus dem Apple-Menü oder klicken Sie im Dock auf das Symbol Systemeinstellungen, um das Fenster Systemeinstellungen zu öffnen. Klicken Sie auf das Symbol Benutzer & Gruppen (oder Konten in älteren Versionen von OS X)

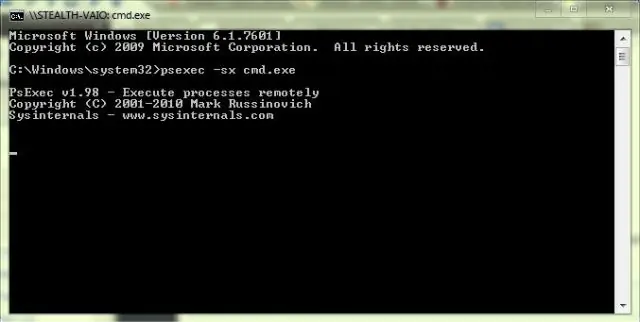

Wie kann ich mein C-Programm an der Eingabeaufforderung ausführen?

Wie kompiliere ich das C-Programm in der Eingabeaufforderung? Führen Sie den Befehl 'gcc -v' aus, um zu überprüfen, ob ein Compiler installiert ist. Erstellen Sie ein c-Programm und speichern Sie es in Ihrem System. Ändern Sie das Arbeitsverzeichnis in das Verzeichnis, in dem Sie Ihr C-Programm haben. Beispiel: >cd-Desktop. Der nächste Schritt ist das Kompilieren des Programms. Im nächsten Schritt können wir das Programm ausführen

Kann ich Windows und Mac auf demselben PC ausführen?

Wenn Sie einen Intel-basierten Mac besitzen, können Sie sowohl OS X als auch Windows auf demselben Computer ausführen. Die meisten PC-Computer verwenden Intel-basierte Chips, was bedeutet, dass Sie jetzt die Betriebssysteme Windows und OS X auf einem Mac-Computer ausführen können

Kann ich Python auf Hadoop ausführen?

Mit der Wahl zwischen Programmiersprachen wie Java, Scala und Python für das Hadoop-Ökosystem verwenden die meisten Entwickler Python aufgrund seiner unterstützenden Bibliotheken für Datenanalyseaufgaben. Hadoop-Streaming ermöglicht es dem Benutzer, Map/Reduce-Jobs mit einem beliebigen Skript oder einer ausführbaren Datei als Mapper oder/und Reducer zu erstellen und auszuführen

Kann ich Malwarebytes und McAfee gleichzeitig ausführen?

Ja Mcafee bietet starken Schutz, aber es wäre schön, Malwarebytes zu verwenden, wenn Sie glauben, dass sich etwas an Mcafee oder dem von Ihnen installierten Produkt geschlichen hat. Es läuft nur während des Scannens