- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Laienhaft gesprochen, die selbst - Beachtung Mechanismus ermöglicht, dass die Eingaben miteinander interagieren („ selbst “) und finden Sie heraus, wen sie mehr bezahlen sollten Beachtung zu ( Beachtung “). Die Ausgänge sind Aggregate dieser Wechselwirkungen und Beachtung punktet.

Und was ist Selbstaufmerksamkeit?

Selbst - Beachtung , manchmal auch als Intra- Beachtung ist ein Beachtung Mechanismus, der verschiedene Positionen einer einzelnen Sequenz in Beziehung setzt, um eine Darstellung der Sequenz zu berechnen.

Und was ist Selbstaufmerksamkeit beim Deep Learning? Zuerst definieren wir, was „ selbst - Beachtung ist. Cheng et al., in ihrer Arbeit mit dem Titel „Long Short-Term Memory-Networks for Maschine Lesen“, definiert selbst - Beachtung als Mechanismus, verschiedene Positionen einer einzelnen Sequenz oder eines Satzes in Beziehung zu setzen, um eine lebendigere Darstellung zu erhalten.

Was ist diesbezüglich der Aufmerksamkeitsmechanismus?

Aufmerksamkeitsmechanismus ermöglicht es dem Decoder, bei jedem Schritt der Ausgabeerzeugung unterschiedliche Teile des Quellsatzes zu berücksichtigen. Anstatt die Eingabesequenz in einen einzelnen festen Kontextvektor zu codieren, lassen wir das Modell lernen, wie ein Kontextvektor für jeden Ausgabezeitschritt generiert wird.

Was ist das Aufmerksamkeitsbasierte Modell?

Beachtung - basierte Modelle gehören zu einer Klasse von Modelle allgemein als Sequenz-zu-Sequenz bezeichnet Modelle . Das Ziel dieser Modelle , wie der Name schon sagt, um eine Ausgabesequenz zu erzeugen, wenn eine Eingabesequenz im Allgemeinen unterschiedlich lang ist.

Empfohlen:

Wie funktioniert der Spring AOP-Proxy?

AOP-Proxy: ein Objekt, das vom AOP-Framework erstellt wurde, um die Aspektverträge zu implementieren (Methodenausführungen beraten usw.). Im Spring Framework ist ein AOP-Proxy ein dynamischer JDK-Proxy oder ein CGLIB-Proxy. Weben: Aspekte mit anderen Anwendungstypen oder Objekten verknüpfen, um ein empfohlenes Objekt zu erstellen

Wie funktioniert ein Spiegelfernseher?

Ein Spiegelfernseher besteht aus speziellem halbtransparentem Spiegelglas mit einem LCD-Fernseher hinter der verspiegelten Fläche. Der Spiegel ist sorgfältig polarisiert, damit ein Bild durch den Spiegel übertragen werden kann, sodass das Gerät bei ausgeschaltetem Fernseher wie ein Spiegel aussieht

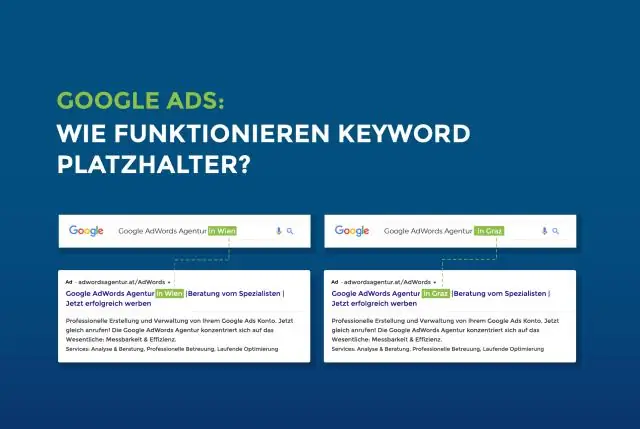

Wie funktioniert Platzhalter?

Das Platzhalterattribut gibt einen kurzen Hinweis an, der den erwarteten Wert eines Eingabefelds beschreibt (z. B. ein Beispielwert oder eine kurze Beschreibung des erwarteten Formats). Hinweis: Das Platzhalterattribut funktioniert mit den folgenden Eingabetypen: Text, Suche, URL, Tel, E-Mail und Passwort

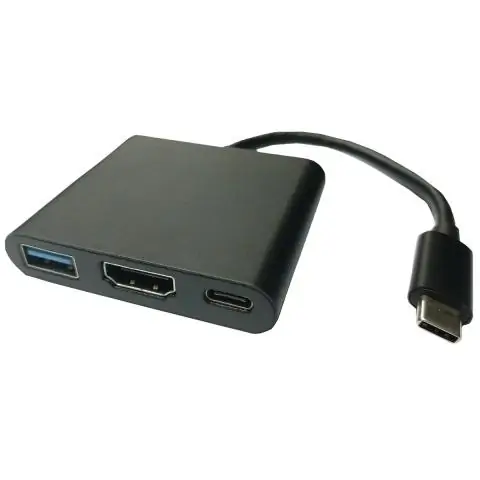

Wie funktioniert ein USB-Display-Adapter?

USB-Videoadapter sind Geräte, die einen USB-Port verwenden und zu einem oder mehreren Videoanschlüssen wie VGA, DVI, HDMI oder DisplayPort gehen. Dies ist nützlich, wenn Sie Ihrem Computer-Setup einen zusätzlichen Bildschirm hinzufügen möchten, aber keine Videoverbindungen auf Ihrem Computer haben

Wie funktioniert der Fehlerkorrekturcode?

Ein fehlerkorrigierender Code ist ein Algorithmus zum Ausdrücken einer Zahlenfolge, so dass jegliche Fehler, die eingeführt werden, erkannt und (innerhalb bestimmter Beschränkungen) basierend auf den verbleibenden Zahlen korrigiert werden können. Das Studium fehlerkorrigierender Codes und der dazugehörigen Mathematik wird als Codierungstheorie bezeichnet