- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Während Funke unterstützt das Laden Dateien von dem lokal Dateisystem, erfordert es, dass die Dateien sind auf allen Knoten in Ihrem Cluster unter demselben Pfad verfügbar. Einige Netzwerkdateisysteme, wie NFS, AFS und die NFS-Schicht von MapR, werden dem Benutzer als normales Dateisystem angezeigt.

Anschließend kann man sich auch fragen, wie führe ich Spark im lokalen Modus aus?

In Lokalbetrieb , Funke Arbeitsplätze Lauf auf einem einzelnen Computer und werden parallel mit Multi-Threading ausgeführt: Dies beschränkt die Parallelität auf (höchstens) die Anzahl der Kerne in Ihrem Computer. Zu Lauf Jobs in Lokalbetrieb , müssen Sie zuerst eine Maschine über SLURM im interaktiven. reservieren Modus und logge dich darin ein.

Was ist außerdem SC textFile? Textdatei ist eine Methode einer org. Apache. SparkContext Klasse, die liest a Textdatei von HDFS, einem lokalen Dateisystem (auf allen Knoten verfügbar) oder einem von Hadoop unterstützten Dateisystem-URI und geben Sie ihn als RDD von Strings zurück.

Was ist in diesem Zusammenhang eine Spark-Datei?

Die Spark-Datei ist ein Dokument, in dem Sie all Ihre kreativen Fähigkeiten aufbewahren. Es wurde vom Autor Stephen Johnson definiert. Anstatt also mitten in der Nacht Notizen auf einem Post-it® zu kratzen oder verschiedene Tagebücher für Ideen zu verwenden, steckst du alle deine Konzepte in einem Datei.

Was ist ein parallelisierter Sammelfunke?

Wir beschreiben später Operationen mit verteilten Datensätzen. Parallelisierte Sammlungen werden durch Aufrufen von JavaSparkContext 's. erstellt parallelisieren Methode auf einem bestehenden Sammlung in Ihrem Treiberprogramm. Die Elemente der Sammlung werden zu einem verteilten Datensatz kopiert, der parallel bearbeitet werden kann.

Empfohlen:

Kann Python ZIP-Dateien lesen?

Um mit Python an Zip-Dateien zu arbeiten, verwenden wir ein integriertes Python-Modul namens zipfile. print ('Fertig!' ZipFile ist eine Klasse des Zipfile-Moduls zum Lesen und Schreiben von Zip-Dateien. Hier importieren wir nur die Klasse ZipFile aus dem Zipfile-Modul

Kann Finale PDF-Dateien lesen?

Profi-Tipp: Sie können die Datei auch im Finale öffnen, indem Sie die Datei in Ihrem Finder auswählen und mit der rechten Maustaste klicken. Wählen Sie dann „Öffnen mit…“und wählen Sie Finale in der Programmleiste. Herzliche Glückwünsche! Sie haben mit ScanScore erfolgreich eine PDF-Datei in Finale importiert

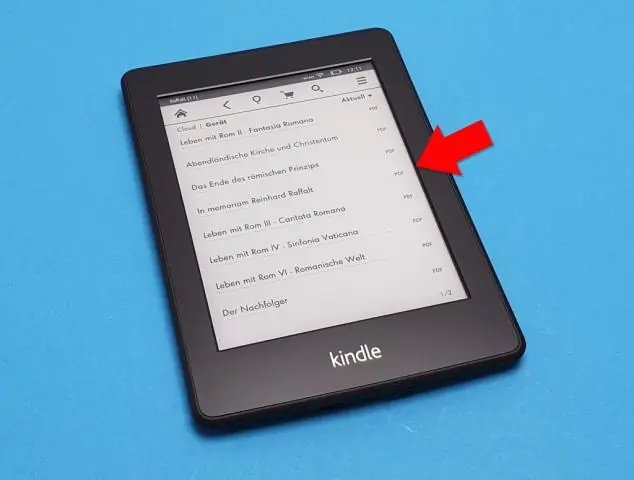

Kann nook PDF-Dateien lesen?

Dokumente, die Sie den Nookinclude-PDFs hinzufügen können, bei denen es sich um Bücher oder andere kürzere Dokumente handeln kann. PDFs auf dem Nook können wie jedes andere gekaufte Buch gelesen werden, und Sie können das Gerät synchronisieren, indem Sie die Dokumente von Ihrem Computer in den Nook kopieren. Doppelklicken Sie auf dem Laufwerk Ihres Nooks auf den Ordner "Bücher" oder "Dokumente"

Kann Python.MAT-Dateien lesen?

Ab Version 7.3 von Matlab werden Mat-Dateien standardmäßig im HDF5-Format gespeichert (außer wenn Sie beim Speichern das Flag -vX verwenden, siehe in Matlab). Diese Dateien können in Python beispielsweise mit dem PyTables- oder h5py-Paket gelesen werden

Kann Windows HEIC-Dateien lesen?

Die HEIF-Image-Erweiterung ermöglicht es Windows 10-Geräten, Dateien zu lesen und zu schreiben, die das HighEfficiency Image File (HEIF)-Format verwenden. Solche Dateien können eine. heic bzw. Wenn das HEVC-Videoerweiterungspaket nicht installiert ist, kann die HEIF-Bilderweiterung weder lesen noch schreiben