Inhaltsverzeichnis:

- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:42.

- Zuletzt bearbeitet 2025-01-22 17:14.

Die Konfigurationsdateien, die aktualisiert werden müssen, um einen vollständig verteilten Modus von Hadoop einzurichten, sind:

- Hadoop-env.sh.

- Core-Site. xml.

- Hdfs-Seite. xml.

- Mapred-Site. xml.

- Meister.

- Sklaven.

Was sind außerdem die wichtigen Konfigurationsdateien in Hadoop?

Die Hadoop-Konfiguration wird von zwei Arten wichtiger Konfigurationsdateien gesteuert:

- Schreibgeschützte Standardkonfiguration - src/core/core-default. xml, src/hdfs/hdfs-default. xml und src/mapred/mapred-default. xml.

- Site-spezifische Konfiguration - conf/core-site. xml, conf/hdfs-site. xml und conf/mapred-site. xml.

Welche der folgenden enthalten Konfigurationen für HDFS-Daemons? xml enthält Konfiguration Einstellungen von HDFS-Daemons (d. h. NameNode, DataNode, Sekundärer NameNode). Es enthält auch den Replikationsfaktor und die Blockgröße von HDFS.

Was sind Konfigurationsdateien in Hadoop?

Konfigurationsdateien sind die Dateien die sich im extrahierten Teer befinden. gz Datei im usw./ hadoop / Verzeichnis. Alle Konfigurationsdateien in Hadoop sind unten aufgeführt, 1) HADOOP -ENV.sh->>Es gibt die Umgebungsvariablen an, die sich auf das JDK auswirken, das von verwendet wird Hadoop Dämon (bin/ hadoop ).

Welche Dateien behandeln Probleme mit kleinen Dateien in Hadoop?

1) HAR ( Hadoop Archiv) Dateien wurde eingeführt Umgang mit kleinen Dateiproblemen . HAR hat eine Ebene darüber eingeführt HDFS , die Schnittstelle für Datei zugreifen. Verwenden von Hadoop Archivbefehl, HAR Dateien erstellt werden, die a Karte verkleinern Job zu packen Dateien in archiviert werden kleiner Anzahl von HDFS-Dateien.

Empfohlen:

Welche Zeichen müssen in XML maskiert werden?

XML-Escape-Zeichen Sonderzeichen-Escape-Form wird durch kaufmännisches Und && Kleiner-als < Anführungszeichen " ' ersetzt

Welche Adressen müssen bei einem Umzug aktualisiert werden?

Der Postdienst der Vereinigten Staaten: Wenn Sie umziehen, sollten Sie als Erstes sicherstellen, dass Ihre Post mit Ihnen transportiert wird! Ändern Sie Ihre Adresse auf der offiziellen USPS® Change-of-Address-Website. Es kostet $1,05, Ihre Adresse mit USPS® zu ändern. Sie können Ihre Adresse auch persönlich in jeder Postfiliale ändern

Welche wichtigen Rollen spielen Menschen in Informationssystemen?

Auf der grundlegendsten Ebene ist ein Informationssystem (IS) ein Satz von Komponenten, die zusammenarbeiten, um die Datenverarbeitung und -speicherung zu verwalten. Seine Rolle besteht darin, die Schlüsselaspekte der Führung einer Organisation zu unterstützen, wie Kommunikation, Aufzeichnungen, Entscheidungsfindung, Datenanalyse und mehr

Welche Faktoren müssen bei der Aufrechterhaltung der Datenintegrität berücksichtigt werden?

Die Datenintegrität kann durch menschliches Versagen oder, noch schlimmer, durch böswillige Handlungen beeinträchtigt werden. Bedrohungen der Datenintegrität Menschliches Versagen. Unbeabsichtigte Übertragungsfehler. Fehlkonfigurationen und Sicherheitsfehler. Malware, Insider-Bedrohungen und Cyberangriffe. Kompromittierte Hardware

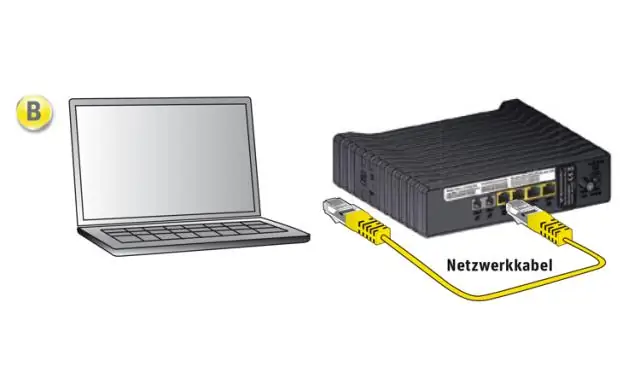

Benötige ich ein Ethernet-Kabel, um einen WLAN-Router einzurichten?

Zuerst müssen Sie Ihren Router mit Ihrem Modem verbinden. Dazu benötigen Sie ein Ethernet-Kabel, das Sie in den WAN-Port (Wide-Area-Network) an der Rückseite Ihres Routers einstecken möchten