Inhaltsverzeichnis:

- Autor Lynn Donovan [email protected].

- Public 2024-01-18 08:20.

- Zuletzt bearbeitet 2025-01-22 17:14.

Die wichtigsten Konfigurationsparameter, die Benutzer im „MapReduce“-Framework angeben müssen, sind:

- Arbeitsplätze Eingabepositionen im verteilten Dateisystem.

- Arbeitsplätze Ausgabeort im verteilten Dateisystem.

- Eingabeformat der Daten.

- Ausgabeformat der Daten.

- Klasse, die die Kartenfunktion enthält.

- Klasse, die die Reduce-Funktion enthält.

Was sind hier die wichtigsten Konfigurationsparameter in einem MapReduce-Programm?

Die wichtigsten Konfigurationsparameter im „MapReduce“-Framework sind:

- Eingabeposition von Jobs im verteilten Dateisystem.

- Ausgabeposition von Jobs im verteilten Dateisystem.

- Das Eingabeformat der Daten.

- Das Ausgabeformat der Daten.

- Die Klasse, die die Kartenfunktion enthält.

- Die Klasse, die die Reduce-Funktion enthält.

Man kann sich auch fragen, was sind die Parameter von Mappern und Reducern? Die vier Parameter für Mapper sind:

- LongWritable (Eingabe)

- Text Eingabe)

- Text (Zwischenausgabe)

- IntWritable (Zwischenausgabe)

Die Frage ist auch, was sind die Hauptkomponenten des MapReduce-Jobs?

- Haupttreiberklasse, die Jobkonfigurationsparameter bereitstellt.

- Mapper-Klasse, die org erweitern muss. Apache. hadoop. Karte verkleinern. Mapper-Klasse und stellen eine Implementierung für die map()-Methode bereit.

- Reduzierklasse, die org erweitern soll. Apache. hadoop. Karte verkleinern. Reduzierklasse.

Was ist Partitionierer und wie hilft er beim MapReduce-Auftragsprozess?

Partitionierer in MapReduce job Die Ausführung steuert die Aufteilung der Schlüssel der Zwischenkartenausgaben. Mit dem Hilfe der Hash-Funktion leitet der Schlüssel (oder eine Untermenge des Schlüssels) die Partition . Datensätze, die denselben Schlüsselwert haben, gehen in denselben Partition (innerhalb jedes Mappers).

Empfohlen:

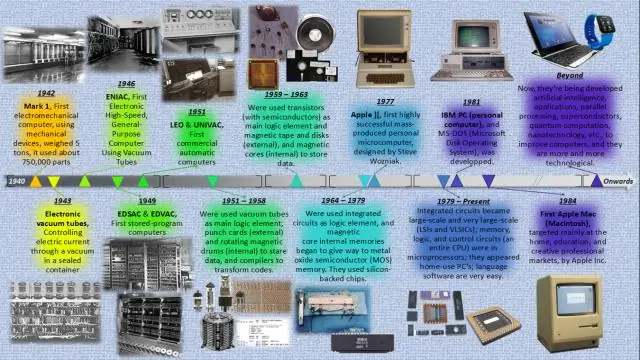

Was sind die wichtigsten Ausgabegeräte der ersten und zweiten Generation von Computersystemen?

Die erste Generation (1940-1956) verwendete Vakuumröhren und die dritte Generation (1964-1971) integrierte Schaltkreise (aber keine Mikroprozessoren). Mainframes der zweiten Generation nutzten Lochkarten für die Ein- und Ausgabe und 9-Spur 1/2″ Magnetbandlaufwerke für die Massenspeicherung und Zeilendrucker für die gedruckte Ausgabe

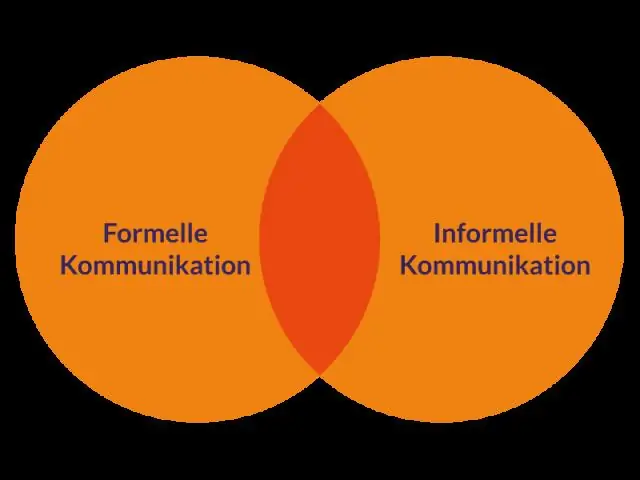

Was sind die wichtigsten Dimensionen der Kommunikation?

Aufgrund dieser Struktur hat Kommunikation viele Dimensionen. Schriftlich und mündlich, einschließlich Zuhören und Sprechen – Schriftliche Kommunikation umfasst Aktivitäten wie das Verfassen von Berichten und Zusammenfassungen sowie das Verfassen von E-Mails

Was sind die wichtigsten Komponenten der Kommunikation?

Ein grundlegendes Kommunikationsmodell besteht aus fünf Komponenten: dem Sender und dem Empfänger, dem Medium, das die Nachricht trägt, kontextuellen Faktoren, der Nachricht selbst und dem Feedback. Um Ihre Botschaften effektiv auszurichten, müssen Sie die Variablen berücksichtigen, die sich auf jede der Komponenten im Modell auswirken können

Wann muss ich eine Adressänderung bei der Post angeben?

Jedes Mal, wenn Sie umziehen, ändert sich Ihre Postanschrift, sodass Sie Ihre Adresse beim United States Postal Service (USPS) ändern müssen, um Ihre Post weiterhin zu erhalten. Sie können Ihre Adresse vor dem Umzug (mindestens 2 Wochen vor dem Auszug) oder direkt nach dem Einzug in die neue Wohnung ändern

Muss ich auf einer Einladung eine Rücksendeadresse angeben?

Auf dem inneren Umschlag ist keine Rücksendeadresse erforderlich. Formal sollte die Rücksendeadresse handschriftlich sein, aber heute ist es akzeptabel, dass diese gedruckt, ein Versandetikett oder ein Rücksendestempel verwendet wird